价格亲民的 Gemini 3 Flash API 定价,畅享全功能服务

Kie.ai 提供极具性价比的 Gemini 3 Flash API 定价方案,让前沿推理模型在实验与大规模生产中的落地切实可行。团队在高效处理实时、高吞吐量任务的同时,能保持成本可控,且无需在推理质量或多模态能力上做出妥协。

Gemini 3 Flash 是由 Google DeepMind 开发的高性能大语言模型,专为提供低延迟、高吞吐量的前沿级推理能力而设计。它在推理、多模态理解和智能体基准测试中表现优异,支持高达 100 万 token 的上下文窗口,是实时、高并发及生产级 AI 工作负载的理想之选。

Automatically append previous messages to maintain multi-turn context. May increase token usage.

Complete guide to using

Kie.ai 的 Gemini 3 Flash API 可实现 Pro 级推理、多模态理解和智能体工作流,兼具低延迟与高效推理的优势。

Gemini 3 Flash(亦称 Gemini 3 Flash Preview)是 Google DeepMind 于 2025 年底推出的 Gemini 3 系列成员,也是一款高速、高性价比的思考型大语言模型 (LLM)。它专为智能体 (Agentic) 工作流、多轮对话和代码辅助而设计,能提供媲美 Pro 级的推理和工具使用性能,且延迟远低于其他大型 Gemini 变体。相比 Gemini 2.5 Flash,Gemini 3 Flash 在推理、多模态理解和可靠性方面均实现了全面提升。 Gemini 3 Flash API 基于该模型构建,以面向生产环境的可编程形式,向开发者开放了 Gemini 3 Flash 的能力。该 API 支持 100 万 (1M) token 的上下文窗口,以及文本、图像、音频、视频和 PDF 等原生多模态输入(输出为文本)。其特性包括可通过思考等级(最低、低、中、高)进行配置的推理能力、结构化输出、工具使用及自动上下文缓存。这使得开发者能够构建交互式应用、长时间运行的智能体循环以及各类现代 LLM 系统,在获得强大推理能力的同时,无需承受全尺寸前沿模型的高成本或高延迟。

Gemini 3 Flash API 提供接近 Pro 级别的推理能力和低延迟推理,推理效率超越 Gemini 2.5 Pro,支持实时和高吞吐量工作负载。通过可配置的思考层级,每个请求都能灵活平衡推理深度、延迟与成本,规模化支持从快速交互到复杂多步工作流的各种场景。

Gemini 3 Flash API 可在统一上下文中原生处理文本、图像、音频、视频和 PDF。这种原生多模态设计使其无需外部编排即可跨多种模态进行推理,从而实现一致的多模态理解与分析。

Gemini 3 Flash API 支持高达 100 万 token 的上下文窗口,能够对长篇文档、长对话及复杂多模态输入进行长上下文推理。即使上下文规模增长,Gemini 3 Flash API 仍旨在保持可预期的延迟与高效性能。

Gemini 3 Flash Preview API 专为智能体系统设计,内置支持工具使用、结构化输出及多轮状态管理。它支持可靠的执行规划、确定性响应,并能在生产级智能体工作流中集成外部工具。

以下基准测试结果横向对比了 Gemini 3 Flash (Gemini 3 Flash Preview) 与其他前沿高性能模型(包括 Gemini 3 Pro、Gemini 2.5 Flash、Gemini 2.5 Pro、Claude Sonnet 4.5、GPT-5.2 和 Grok 4.1 Fast)的表现。评测涵盖了学术推理、多模态理解、数学、编程、智能体工具调用、长程工作流、事实准确性、多语言推理以及长上下文性能等标准化评估维度。本表旨在从能力角度宏观展示各模型的相对推理强度和任务覆盖范围(不考虑价格因素),请将其视为各项能力的对比快照,而非单一维度的排名依据。

| 评测类别 | 基准测试 | 说明 | Gemini 3 Flash | Gemini 3 Pro | Gemini 2.5 Flash | Gemini 2.5 Pro | Claude Sonnet 4.5 | GPT-5.2 | Grok 4.1 Fast |

|---|---|---|---|---|---|---|---|---|---|

| Academic Reasoning | Humanity’s Last Exam | No tools | 33.70% | 37.50% | 11.00% | 21.60% | 13.70% | 34.50% | 17.60% |

| Academic Reasoning | Humanity’s Last Exam | With search & code | 43.50% | 45.80% | — | — | — | 45.50% | — |

| Visual Reasoning | ARC-AGI-2 | ARC Prize verified | 33.60% | 31.10% | 2.50% | 4.90% | 13.60% | 52.90% | — |

| Scientific Knowledge | GPQA Diamond | No tools | 90.40% | 91.90% | 82.80% | 86.40% | 83.40% | 92.40% | 84.30% |

| Mathematics | AIME 2025 | No tools | 95.20% | 95.00% | 72.00% | 88.00% | 87.00% | 100% | 91.90% |

| Mathematics | AIME 2025 | With code execution | 99.70% | 100% | 75.70% | — | 100% | — | — |

| Multimodal Reasoning | MMMU-Pro | — | 81.20% | 81.00% | 66.70% | 68.00% | 68.00% | 79.50% | 63.00% |

| Screen Understanding | ScreenSpot-Pro | No tools unless noted | 69.10% | 72.70% | 3.90% | 11.40% | 36.20% | 86.30% | — |

| Chart Reasoning | CharXiv Reasoning | No tools | 80.30% | 81.40% | 63.70% | 69.60% | 68.50% | 82.10% | — |

| OCR | OmniDocBench 1.5 | Edit distance ↓ | 0.121 | 0.115 | 0.154 | 0.145 | 0.145 | 0.143 | — |

| Video Understanding | Video-MMMU | — | 86.90% | 87.60% | 79.20% | 83.60% | 77.80% | 85.90% | — |

| Competitive Coding | LiveCodeBench Pro | Elo ↑ | 2316 | 2439 | 1143 | 1775 | 1418 | 2393 | — |

| Agentic Coding | SWE-bench Verified | Single attempt | 78.00% | 76.20% | 60.40% | 59.60% | 77.20% | 80.00% | 50.60% |

| Agentic Tool Use | τ²-bench | — | 90.20% | 90.70% | 79.50% | 77.80% | 87.20% | — | — |

| Long-Horizon Tasks | Toolathlon | — | 49.40% | 36.40% | 3.70% | 10.50% | 38.90% | 46.30% | — |

| Multi-Step Workflows | MCP Atlas | — | 57.40% | 54.10% | 3.40% | 8.80% | 43.80% | 60.60% | — |

| Factuality | FACTS Benchmark Suite | — | 61.90% | 70.50% | 50.40% | 63.40% | 48.90% | 61.40% | 42.10% |

| Multilingual Q&A | MMMLU | — | 91.80% | 91.80% | 86.60% | 89.50% | 89.10% | 89.60% | 86.80% |

| Commonsense | Global PIQA | — | 92.80% | 93.40% | 90.20% | 91.50% | 90.10% | 91.20% | 85.60% |

| Long Context | MRCR v2 (8-needle) | 128k avg | 67.20% | 77.00% | 54.30% | 58.00% | 47.10% | 81.90% | 54.60% |

| Long Context | MRCR v2 (8-needle) | 1M pointwise | 22.10% | 26.30% | 21.00% | 16.40% | — | — | 6.10% |

只需简单几步,即可快速上手我们的产品……

在 Kie.ai 上创建账户并申请 Gemini 3 Flash API 的访问权限。注册完成后,请在 Kie.ai 控制台生成您的 Gemini 3 Flash API Key,并将其绑定至相应环境。该 Key 用于身份验证和请求归属,请务必遵循标准生产安全规范进行存储、定期轮换和管理。

定义 Gemini 3 Flash Preview API 在您系统中的部署策略,包括预估请求量、并发限制及延迟目标。通过调整“思考层级(thinking levels)”来配置推理行为,在推理速度与深度之间取得平衡,确保在生产流量下性能稳定可控。

定义支持的输入模态及响应格式,将 Gemini 3 Flash API 集成至您的技术栈。针对智能体(Agent)及自动化系统,启用结构化输出与工具调用功能,以确保响应的确定性以及与下游服务交互的可靠性。明确的输入输出契约是保障多轮对话工作流稳定的关键。

在全面上线前,请在真实流量模式下对 Gemini 3 Flash API 进行验证,涵盖高并发、长上下文使用及多轮交互等场景。监控不同配置下的延迟分布、Token 消耗及推理行为,并据此调整部署参数,确保随着用量增长,系统仍能维持稳定运行。

Gemini 3 Flash API 能够在单一上下文中对图像、图表及多页文档进行近实时推理。这一能力支持企业级搜索、数据分析仪表盘以及大规模知识提取工作流等应用场景。

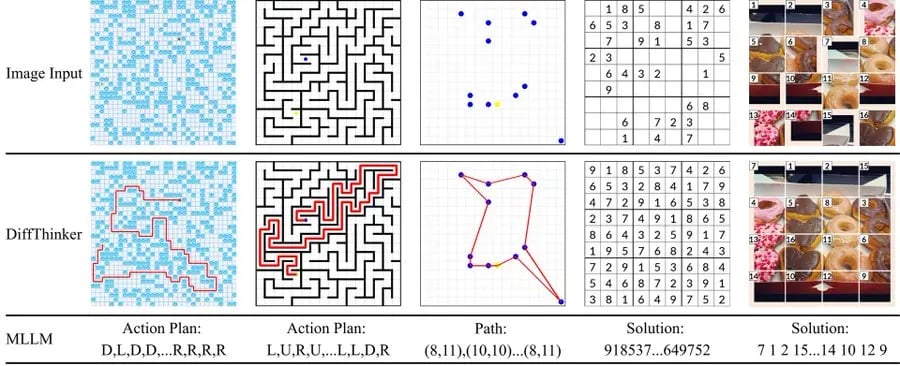

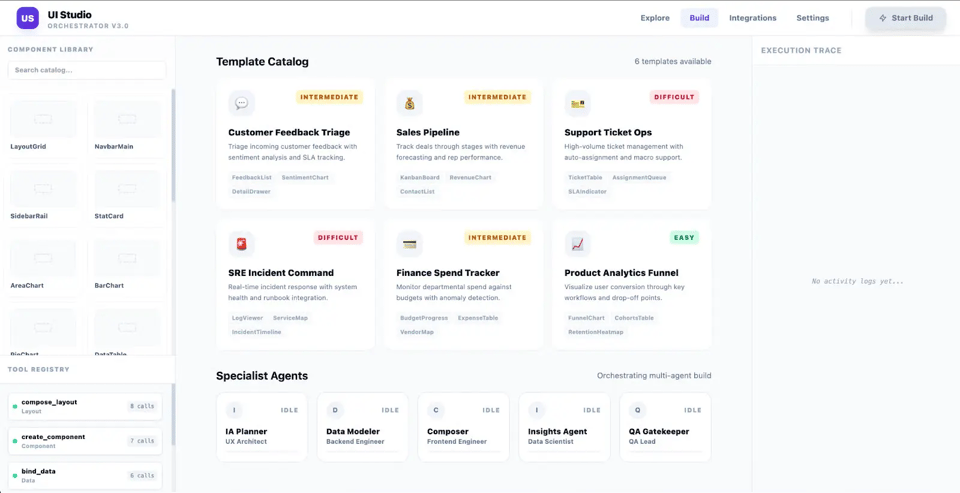

Gemini 3 Flash Preview API 能将设计输入、草图或 UI 效果图转化为功能代码或交互式预览,从而加速原型开发。借助多模态推理能力,它大幅缩短了从概念到可运行原型的周期。

Gemini 3 Flash API 支持有状态的多轮智能体工作流及可靠的工具调用。这使得自动化助手和后端系统能够执行规划、编排及条件执行等复杂的多步骤任务。

Gemini 3 Flash Preview API 为开发者工具提供兼具 Flash 级延迟与近乎 Pro 级的代码推理能力。它支持实时代码建议、调试辅助,并能在快速变动的代码库中实现上下文感知生成。

Gemini 3 Flash API 能够快速理解视频内容,提取语义语境与可落地的洞察。该能力非常适用于体育赛事分析、交互式系统以及实时决策支持等场景。

Gemini 3 Flash Preview API 赋能具备上下文感知能力的内容生成,可根据多模态输入动态调整。它全面支持个性化学习体验、自适应内容工作流以及规模化的针对性内容创作。

Kie.ai 提供极具性价比的 Gemini 3 Flash API 定价方案,让前沿推理模型在实验与大规模生产中的落地切实可行。团队在高效处理实时、高吞吐量任务的同时,能保持成本可控,且无需在推理质量或多模态能力上做出妥协。

Kie.ai 提供全方位的 Gemini 3 Flash API 文档,涵盖模型配置、推理控制、多模态输入、结构化输出及部署考量。清晰的参考规范与系统化指南,助您的团队快速上手、高效集成,从原型开发平滑过渡到生产落地。

Kie.ai 提供全天候的 Gemini 3 Flash API 服务,依托专为持续高可用性设计的生产级基础设施。这确保了即便是对延迟极度敏感的关键业务应用,在面对持续高流量和真实负载环境时,也能实现 7x24 小时稳定运行。