基于大上下文窗口的长文档分析

适用于需要在单次请求中处理完整报告、合同或大型数据集的文档分析与审查场景。通过调用 Gemini 2.5 Pro API,后端系统无需手动分块即可返回完整且连贯的结果,从而有效保留文档结构、引用关系及整体一致性。

Gemini 2.5 Pro 是谷歌推出的先进“思考”模型,专为处理复杂推理、代码生成及长上下文理解任务而设计。它支持原生多模态输入,提供高达 100 万 token 的上下文窗口,可满足深度的分析与开发工作流需求。

Automatically append previous messages to maintain multi-turn context. May increase token usage.

Complete guide to using

集成 Gemini 2.5 Pro API,支持 100 万 token 上下文、高级推理和多模态输入——现已登陆 Kie.ai,提供更优惠的按量计费方案。

Gemini 2.5 Pro API 专为需要多步推理而非快速模式匹配的任务而设计。它广泛应用于规划、分析和决策类工作流,在此类场景中,贯穿全程的逻辑一致性远比轻量级响应更为关键。

Gemini 2.5 Pro 模型能够将简短的提示词转化为完整的可运行代码,而非零散的片段。利用 Gemini 2.5 Pro API,您可以快速构建原型——仅需单行提示词即可生成驱动小型应用或交互体验的可执行代码。

Gemini 2.5 Pro API 具备原生多模态能力,支持在单一工作流中融合多种输入类型。当解决方案依赖多源信息时,它能对文本、图像、音频、视频及代码进行综合推理。

Gemini 2.5 Pro API 的核心优势在于其长上下文支持,拥有高达 100 万 Token 的上下文窗口。这使其能够一次性处理大型文档、超长对话历史或完整的项目上下文。同时,上下文缓存功能可复用背景信息,优化重复请求的效率。

Gemini 2.5 Pro API 采用内部思考过程来增强多步推理和规划能力。它默认启用动态思考模式,根据每个请求的复杂程度自动调整推理深度。

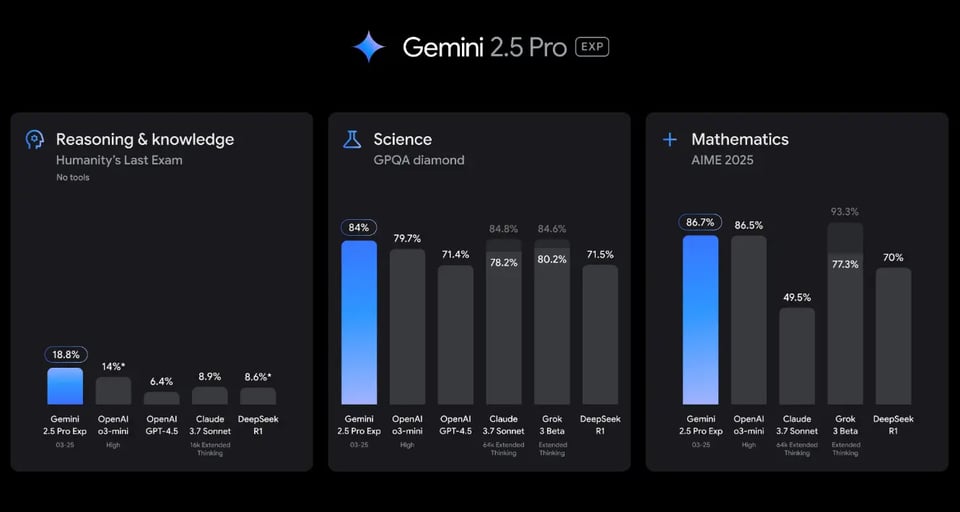

| 性能评测专区 | Gemini 2.5 Pro | OpenAI o3-mini | OpenAI GPT-4.5 | Claude 3.7 Sonnet | Grok 3 Beta | |

|---|---|---|---|---|---|---|

| Reasoning & knowledge | Humanity’s Last Exam (no tools) | 18.80% | 14.00%* | 6.40% | 8.90% | – |

| Science | GPQA Diamond (single attempt, pass@1) | 84.00% | 79.70% | 71.40% | 78.20% | 80.20% |

| Mathematics | AIME 2025 (single attempt, pass@1) | 86.70% | 86.50% | – | 49.50% | 77.30% |

| Code generation | LiveCodeBench v5 (single attempt, pass@1) | 70.40% | 74.10% | – | – | 70.60% |

| Code editing | Aider Polyglot | 74.0% / 68.6% (whole / diff) | 60.4% (diff) | 44.9% (diff) | 64.9% (diff) | – |

| Visual reasoning | MMMU (single attempt, pass@1) | 81.70% | no MM support | 74.40% | 75.00% | 76.00% |

| Long context | MRCR (128k average) | 94.50% | 61.40% | 64.00% | – | – |

注册 Kie.ai 账号并在控制台生成您的 API 密钥。请妥善保管密钥,用于在调用 Gemini 2.5 Pro API 时进行身份验证。

发送 POST 请求创建任务,并指定 gemini-2.5-pro 为模型。请参考 Gemini 2.5 Pro API 文档中的请求格式,在结构化 JSON 请求体中提供您的输入内容。

任务完成后,您可以主动获取结果,或通过配置的回调函数接收数据。请根据您的业务逻辑和 API 配额限制,使用响应数据处理输出内容、错误信息及用量统计。

相比官方渠道,Kie.ai 为 Gemini 2.5 Pro API 提供了更具成本效益的定价模式。我们采用基于 Credit 体系的按量计费方式,团队可以灵活扩展用量,无强制保底,确保长上下文任务的成本可控。

Kie.ai 提供清晰实用的 Gemini 2.5 Pro API 文档,涵盖请求参数、请求结构、示例、回调机制及关键接入说明。此外,我们提供 24 小时技术支持,协助开发者排查问题,助力项目从测试阶段平滑过渡到生产环境。

Kie.ai 的 Gemini 2.5 Pro API 专为真实生产环境设计,能够可靠地处理并发 API 调用。它非常适合后端服务、内部工具以及在持续流量下需要保持稳定性能的应用场景。

平台内置安全与可观测性机制。Kie.ai 提供完善的 API 密钥管理功能,支持 IP 白名单、速率限制及详细请求日志。这有助于团队在生产环境中调用 Gemini 2.5 Pro API 时,有效审计用量、排查故障并降低风险。

适用于需要在单次请求中处理完整报告、合同或大型数据集的文档分析与审查场景。通过调用 Gemini 2.5 Pro API,后端系统无需手动分块即可返回完整且连贯的结果,从而有效保留文档结构、引用关系及整体一致性。

常集成于各类开发工具与内部服务,用于将自然语言需求转化为可执行代码。Gemini 2.5 Pro API 能在单次响应中返回完整的脚本或应用逻辑,非常适合快速原型开发与自动化工作流。

适用于分析混合输入的场景,如附带日志的截图、包含描述的图片或带有元数据的短视频。通过向 Gemini 2.5 Pro API 发送多模态数据,系统仅需一次调用即可获得结构化分析结果,从而简化下游处理流程。

Gemini 3 Pro 是最新一代 Gemini 模型,专为更高级的推理和复杂多模态任务而设计。当需要超越 Gemini 2.5 Pro 的更高准确性、更深层推理能力或处理要求更高的工作负载时,通常会选用该模型。

Gemini 3 Flash 侧重于速度与效率。对于相比深度多步推理更看重低延迟和低成本的高吞吐量应用(例如实时响应、轻量级分析或海量请求),该模型是非常合适的选择。

在 2.5 代产品中,Gemini 2.5 Flash 提供了性能与成本的平衡选项。开发者通常将其用于响应更快、任务更常规的场景,而将 Gemini 2.5 Pro API 保留用于长上下文分析、复杂推理或代码生成等工作负载。